Nye publikationer

Kardiologer har trænet en stor AI-model til at vurdere hjertets struktur og funktion

Sidst revideret: 02.07.2025

Alt iLive-indhold gennemgås medie eller kontrolleres for at sikre så meget faktuel nøjagtighed som muligt.

Vi har strenge sourcing retningslinjer og kun link til velrenommerede medie websteder, akademiske forskningsinstitutioner og, når det er muligt, medicinsk peer reviewed undersøgelser. Bemærk at tallene inden for parentes ([1], [2] osv.) Er klikbare links til disse undersøgelser.

Hvis du mener, at noget af vores indhold er unøjagtigt, forældet eller på anden måde tvivlsomt, skal du vælge det og trykke på Ctrl + Enter.

Eksperter i kunstig intelligens hos Cedars-Sinai og Smidt Heart Institute har skabt et datasæt med mere end 1 million ekkokardiogrammer (videoultralydsbilleder af hjertet) og deres tilsvarende kliniske fortolkninger. Ved hjælp af denne database udviklede de EchoCLIP, en kraftfuld maskinlæringsalgoritme, der kan "fortolke" ekkokardiogrammer og vurdere vigtige målinger.

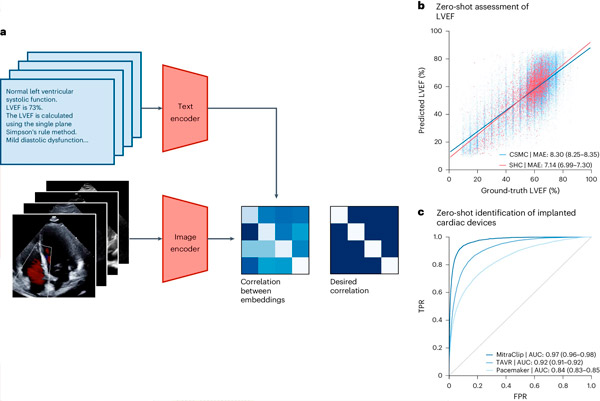

Designet og evalueringen af EchoCLIP, beskrevet i en artikel offentliggjort i Nature Medicine, tyder på, at fortolkning af en patients ekkokardiogram ved hjælp af EchoCLIP giver kliniske vurderinger på specialistniveau, herunder vurdering af hjertefunktion, resultater af tidligere operationer og implanterede enheder, og kan hjælpe læger med at identificere patienter, der har brug for behandling.

EchoCLIP-basismodellen kan også identificere den samme patient på tværs af flere videoer, undersøgelser og tidspunkter og genkende klinisk vigtige ændringer i patientens hjerte.

"Så vidt vi ved, er dette den største model, der er trænet på ekkokardiografibilleder," sagde hovedforfatter af studiet, David Ouyang, MD, et fakultetsmedlem i Division of Cardiology på Smidt Heart Institute og Division of Artificial Intelligence in Medicine.

"Mange tidligere AI-modeller til ekkokardiogrammer er kun trænet på titusindvis af eksempler. I modsætning hertil er EchoCLIPs enestående høje ydeevne inden for billedfortolkning resultatet af træning på næsten ti gange flere data end eksisterende modeller."

"Vores resultater viser, at store datasæt af medicinsk billeddannelse og ekspertverificerede fortolkninger kan tjene som grundlag for træning af grundlæggende medicinske modeller, som er en form for generativ kunstig intelligens," tilføjede Ouyang.

EchoCLIP-arbejdsgang. Kilde: Nature Medicine (2024). DOI: 10.1038/s41591-024-02959-y

Han bemærkede, at denne avancerede basismodel snart kunne hjælpe kardiologer med at evaluere ekkokardiogrammer ved at generere estimater af hjertemålinger, identificere ændringer over tid og almindelige sygdomme.

Forskerholdet skabte et datasæt med 1.032.975 ultralydsvideoer af hjertet og tilsvarende ekspertfortolkninger for at udvikle EchoCLIP. De vigtigste resultater fra undersøgelsen inkluderer:

- EchoCLIP viste høj ydeevne i vurderingen af hjertefunktion ud fra hjertebilleder.

- Baselinemodellen var i stand til at identificere implanterede intrakardiale enheder såsom pacemakere, mitralklappimplantater og aortaklapimplantater ud fra ekkokardiogrambilleder.

- EchoCLIP identificerede præcist unikke patienter på tværs af studier, detekterede klinisk vigtige ændringer såsom tidligere hjertekirurgi og muliggjorde udviklingen af foreløbige tekstfortolkninger af ekkokardiogrambilleder.

"Grundlæggende modeller er et af de nyeste områder inden for generativ kunstig intelligens, men de fleste modeller har ikke nok medicinske data til at være nyttige i sundhedsvæsenet," sagde Christina M. Albert, MD, MPH, formand for Division of Cardiology på Smidt Heart Institute.

Albert, som ikke var involveret i undersøgelsen, tilføjede: "Denne nye basismodel integrerer computersyn til fortolkning af ekkokardiogrambilleder med naturlig sprogbehandling for at forbedre kardiologers fortolkninger."